视频可以精准控制了!一句话给熊戴眼镜的那种,扩散模型立功,浙大悉尼科技大学出品 | ICLR 2025

视频可以精准控制了!一句话给熊戴眼镜的那种,扩散模型立功,浙大悉尼科技大学出品 | ICLR 2025如何让你的模型能感知到视频的粒度,随着你的心思想编辑哪就编辑哪呢?

如何让你的模型能感知到视频的粒度,随着你的心思想编辑哪就编辑哪呢?

块离散去噪扩散语言模型(BD3-LMs)结合自回归模型和扩散模型的优势,解决了现有扩散模型生成长度受限、推理效率低和生成质量低的问题。通过块状扩散实现任意长度生成,利用键值缓存提升效率,并通过优化噪声调度降低训练方差,达到扩散模型中最高的预测准确性,同时生成效率和质量优于其他扩散模型。

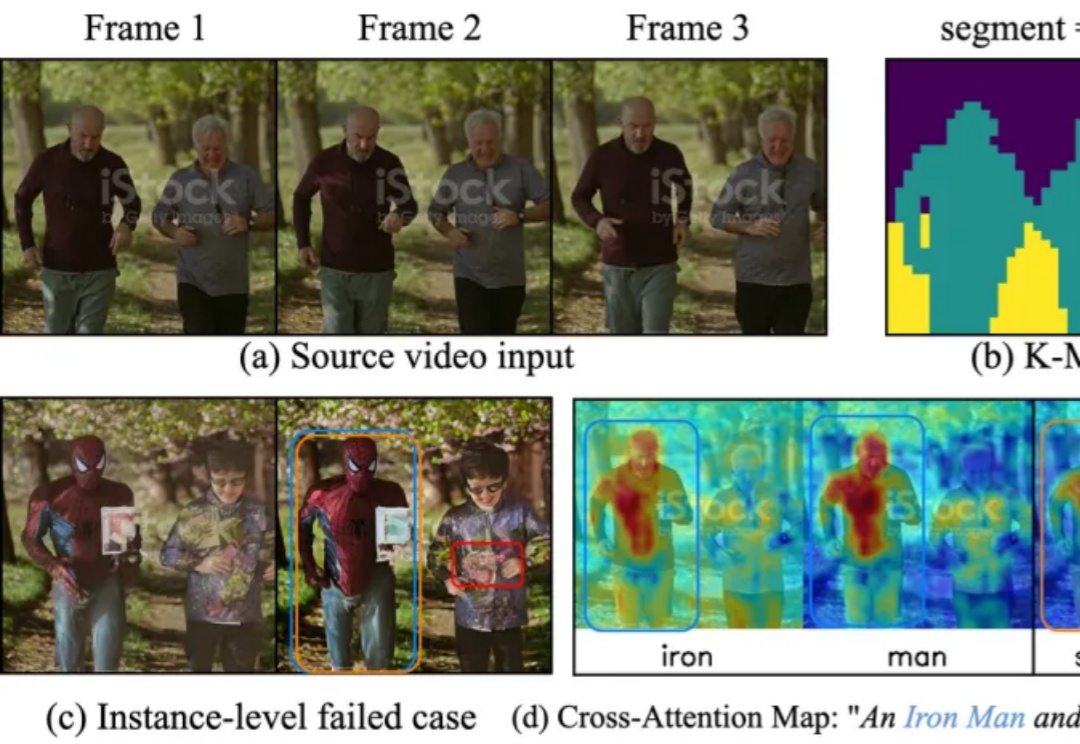

最近,全球 AI 和机器学习顶会 ICLR 2025 公布了论文录取结果:由蚂蚁数科与清华大学联合团队提出的全新具身协同框架 BodyGen 成功入选 Spotlight(聚光灯/特别关注)论文。

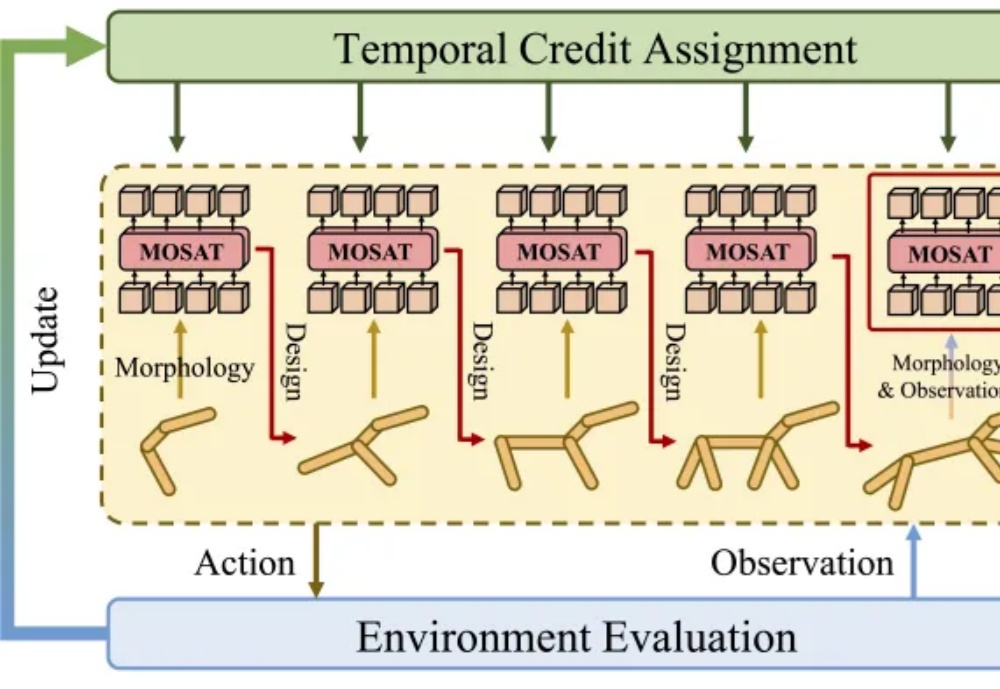

在深度学习的多个应用场景中,联合优化多个损失项是一个普遍的问题。典型的例子包括物理信息神经网络(Physics-Informed Neural Networks, PINNs)、多任务学习(Multi-Task Learning, MTL)和连续学习(Continual Learning, CL)。然而,不同损失项的梯度方向往往相互冲突,导致优化过程陷入局部最优甚至训练失败。

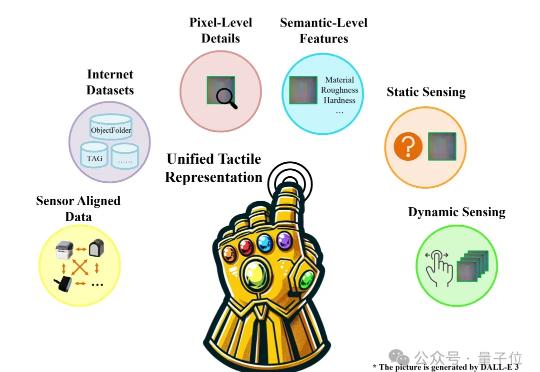

机器人怎样感知世界?

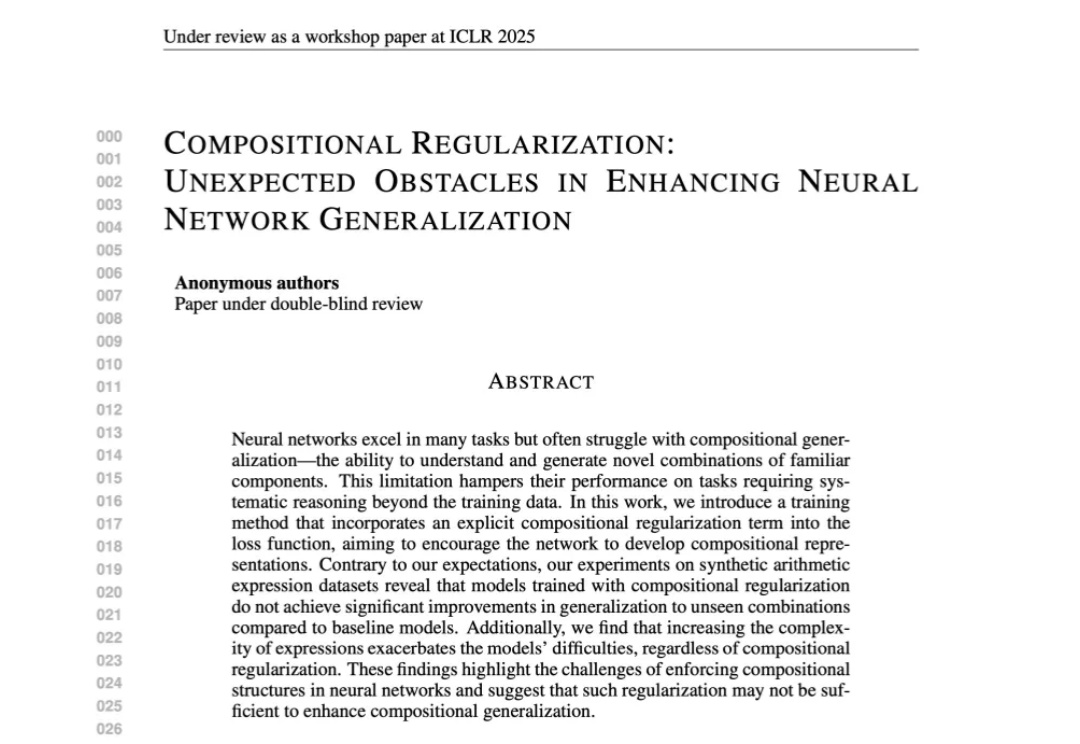

Sakana AI刚刚官宣,第二代「AI科学家」独立完成论文,通过了ICLR 2025 Workshop的同行评审。这是首次完全由AI端到端生成的科学论文,获得了学术高度认可。

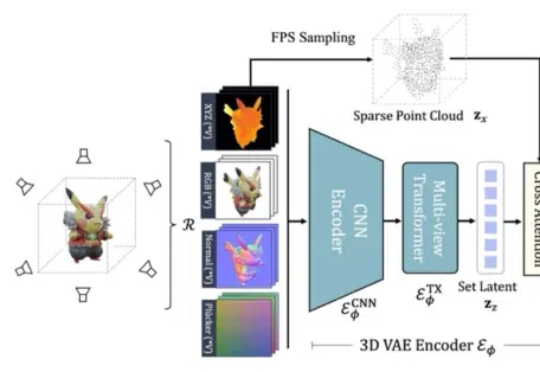

在 ICLR 2025 中,来自南洋理工大学 S-Lab、上海 AI Lab、北京大学以及香港大学的研究者提出的基于 Flow Matching 技术的全新 3D 生成框架 GaussianAnything,针对现有问题引入了一种交互式的点云结构化潜空间,实现了可扩展的、高质量的 3D 生成,并支持几何-纹理解耦生成与可控编辑能力。

来自哥本哈根大学、苏黎世联邦理工学院等机构的研究人员,提出了一个全新的多模态Few-shot 3D分割设定和创新方法。无需额外标注成本,该方法就可以融合文本、2D和3D信息,让模型迅速掌握新类别。

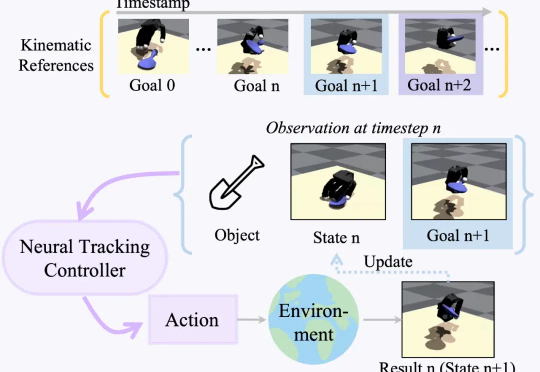

现实世界的机器人距离科幻小说里的机器人世界还有多远?通用灵巧操控何时才能实现?朝着这一伟大的目标,研究通用灵巧操控轨迹跟踪的 DexTrack 便应用而生。

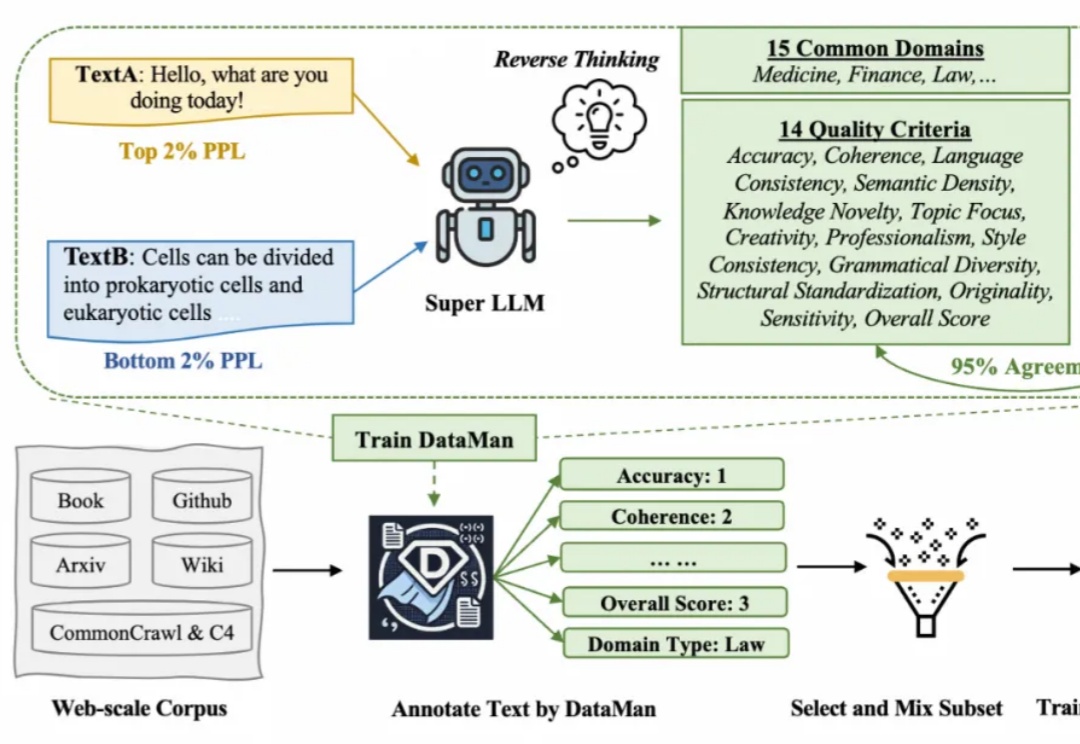

在 Scaling Law 背景下,预训练的数据选择变得越来越重要。然而现有的方法依赖于有限的启发式和人类的直觉,缺乏全面和明确的指导方针。在此背景下,该研究提出了一个数据管理器 DataMan,其可以从 14 个质量评估维度对 15 个常见应用领域的预训练数据进行全面质量评分和领域识别。